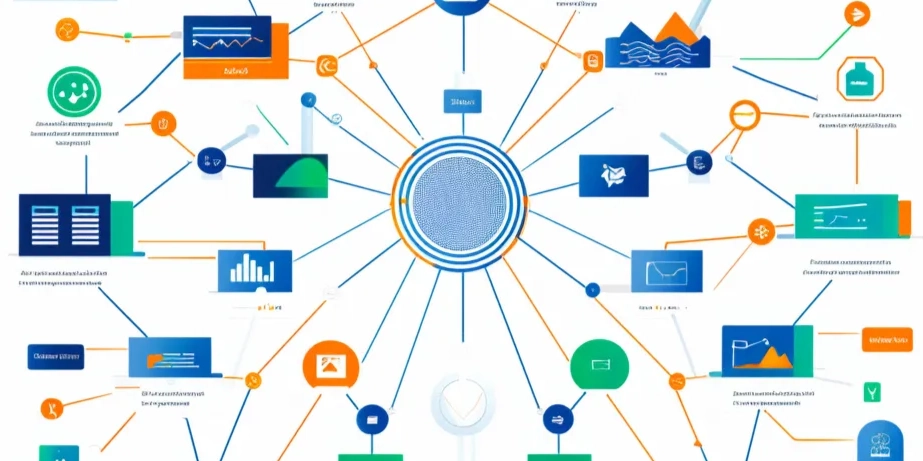

自然语言处理(NLP)作为人工智能的核心领域之一,近年来在预训练模型、低资源语言处理、多模态融合等方面取得了显著进展。本文将围绕这些最新研究方向展开,探讨其在不同场景下的应用、挑战及解决方案,并结合实际案例分享个人见解。

1. 预训练模型的改进与应用

1.1 预训练模型的现状

预训练模型(如BERT、GPT系列)已成为NLP领域的基石。它们通过大规模数据训练,能够捕捉语言的深层次特征,显著提升了文本分类、问答系统等任务的性能。

1.2 改进方向

- 模型压缩与加速:随着模型规模的增大,如何在保持性能的同时降低计算成本成为关键。例如,知识蒸馏技术可以将大模型的知识迁移到小模型中。

- 领域自适应:通用预训练模型在特定领域(如医疗、法律)表现不佳,如何通过微调或领域预训练提升效果是研究热点。

1.3 应用场景

- 企业知识管理:通过预训练模型构建智能问答系统,帮助企业快速检索内部文档。

- 客户服务:利用预训练模型优化聊天机器人,提升客户满意度。

2. 低资源语言处理技术

2.1 低资源语言的挑战

低资源语言(如少数民族语言)由于缺乏标注数据,难以直接应用现有NLP技术。

2.2 解决方案

- 迁移学习:利用高资源语言(如英语)的模型进行迁移,通过少量标注数据微调。

- 数据增强:通过合成数据或跨语言对齐技术,扩充低资源语言的训练数据。

2.3 实际案例

- 少数民族语言翻译:某公司通过迁移学习技术,成功开发了藏语-汉语翻译系统,促进了文化交流。

3. 多模态信息融合

3.1 多模态的定义

多模态指结合文本、图像、音频等多种信息源进行联合处理。

3.2 研究进展

- 跨模态对齐:如何将不同模态的信息对齐,例如将图像中的物体与文本描述匹配。

- 多模态预训练:如CLIP模型,通过联合训练文本和图像,实现了跨模态的语义理解。

3.3 应用场景

- 智能广告:通过分析用户上传的图片和文字,精准推荐相关产品。

- 医疗诊断:结合医学影像和病历文本,辅助医生做出更准确的诊断。

4. 对话系统与人机交互优化

4.1 对话系统的现状

当前对话系统在开放域对话中仍存在理解偏差和生成不连贯的问题。

4.2 优化方向

- 上下文建模:通过更复杂的上下文记忆机制,提升对话的连贯性。

- 情感理解:引入情感分析技术,使对话系统能够感知用户情绪并做出适当回应。

4.3 实际案例

- 智能客服:某银行通过优化对话系统,将客户满意度提升了20%。

5. 文本生成的质量与多样性提升

5.1 文本生成的挑战

现有文本生成模型容易产生重复、无意义的内容,且缺乏多样性。

5.2 改进方法

- 多样性控制:通过调整采样策略或引入多样性损失函数,提升生成内容的丰富性。

- 后处理优化:利用规则或小模型对生成文本进行修正,减少错误。

5.3 应用场景

- 内容创作:帮助自媒体快速生成高质量的文章初稿。

- 代码生成:辅助开发者自动生成代码片段,提升开发效率。

6. 自然语言理解中的可解释性

6.1 可解释性的重要性

随着NLP模型在关键领域(如司法、医疗)的应用,其决策过程的可解释性变得至关重要。

6.2 研究方向

- 注意力机制分析:通过可视化注意力权重,理解模型关注的重点。

- 规则嵌入:将人类可理解的规则嵌入模型,提升决策的透明性。

6.3 实际案例

- 司法判决辅助:某法院通过可解释的NLP模型,辅助法官分析案件文本,提升了判决的公正性。

总结:自然语言处理的最新研究方向涵盖了预训练模型的改进、低资源语言处理、多模态融合、对话系统优化、文本生成质量提升以及可解释性研究。这些方向不仅推动了技术的进步,也在企业信息化和数字化中发挥了重要作用。从实践来看,未来的NLP技术将更加注重实际场景的适配性和用户体验的提升,同时也需要解决模型复杂性与可解释性之间的矛盾。作为CIO,我认为企业应积极拥抱这些技术,通过合理的应用场景选择和持续的技术优化,实现业务价值的最大化。

原创文章,作者:IT_admin,如若转载,请注明出处:https://docs.ihr360.com/strategy/it_strategy/164106