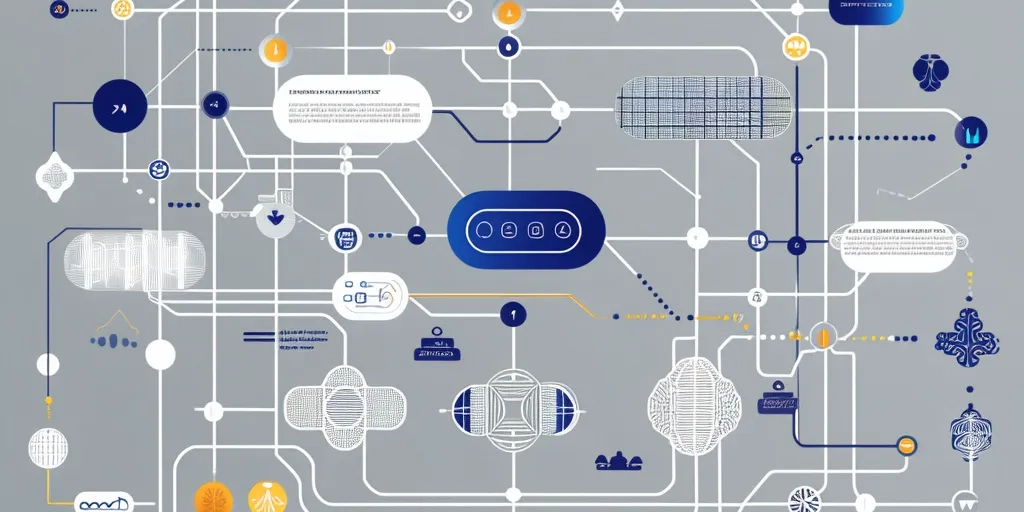

数据仓库架构的设计是支持大规模数据分析的核心。本文将从数据仓库的基本组成、存储与管理策略、计算框架选择、ETL流程优化、查询性能优化以及高可用性方案六个方面,深入探讨如何构建一个高效、可扩展的数据仓库架构,帮助企业应对海量数据的挑战。

一、数据仓库架构的基本组成

数据仓库架构通常由以下几个核心组件构成:

- 数据源层:包括企业内部系统(如ERP、CRM)和外部数据(如社交媒体、物联网设备)。数据源层是数据仓库的基础,决定了数据的多样性和复杂性。

- 数据集成层:负责数据的抽取、转换和加载(ETL),将分散的数据整合到统一的存储系统中。

- 数据存储层:包括关系型数据库、NoSQL数据库或分布式文件系统(如HDFS),用于存储结构化、半结构化和非结构化数据。

- 数据处理层:提供批处理和实时计算能力,支持复杂的数据分析和机器学习任务。

- 数据服务层:通过API或查询接口向业务系统提供数据服务,支持报表生成、数据可视化等应用。

从实践来看,一个优秀的数据仓库架构需要具备高扩展性和灵活性,以应对数据量和业务需求的快速增长。

二、数据存储与管理策略

在大规模数据分析场景中,数据存储与管理策略直接影响系统的性能和成本。以下是几种常见的策略:

- 分层存储:根据数据的热度(访问频率)将数据分为热数据、温数据和冷数据,分别存储在高性能存储(如SSD)、普通磁盘和低成本存储(如对象存储)中。

- 数据分区与分片:通过水平分区(如按时间或地域)和垂直分片(如按业务模块)优化数据存储和查询性能。

- 数据压缩与编码:采用列式存储(如Parquet、ORC)和压缩算法(如Snappy、Zstandard)减少存储空间占用,同时提升查询效率。

我认为,分层存储和数据分区是应对大规模数据存储挑战的关键策略,能够显著降低存储成本并提高查询性能。

三、数据处理与计算框架选择

数据处理与计算框架的选择直接影响数据分析的效率和灵活性。以下是几种主流框架及其适用场景:

- 批处理框架:如Apache Hadoop和Apache Spark,适用于大规模离线数据分析。Spark凭借其内存计算能力,在处理复杂ETL任务时表现尤为出色。

- 流处理框架:如Apache Flink和Apache Kafka Streams,适用于实时数据分析场景,能够处理高吞吐量的数据流。

- 混合计算框架:如Delta Lake和Apache Iceberg,支持批处理和流处理的统一,简化了数据湖和数据仓库的集成。

从实践来看,Spark和Flink是目前最受欢迎的计算框架,能够满足大多数企业的需求。

四、数据集成与ETL流程优化

数据集成是数据仓库设计的核心环节,ETL流程的优化直接影响数据质量和处理效率。以下是几点优化建议:

- 增量抽取:通过日志捕获(如CDC)或时间戳过滤,减少全量抽取的开销。

- 并行处理:将ETL任务分解为多个子任务并行执行,充分利用计算资源。

- 数据质量监控:在ETL过程中加入数据校验和清洗规则,确保数据的准确性和一致性。

我认为,增量抽取和并行处理是提升ETL效率的关键,能够显著缩短数据处理时间。

五、查询性能优化与索引策略

查询性能是数据仓库的核心指标之一,以下是几种常见的优化策略:

- 索引优化:根据查询模式创建合适的索引(如B树索引、位图索引),加速数据检索。

- 物化视图:预计算常用查询结果,减少实时计算的开销。

- 查询重写:通过优化SQL语句(如减少子查询、避免全表扫描)提升查询效率。

从实践来看,物化视图和索引优化是提升查询性能的有效手段,尤其适用于复杂查询场景。

六、高可用性与容灾方案

高可用性和容灾能力是数据仓库设计的重要考量。以下是几种常见的方案:

- 多副本存储:通过分布式存储系统(如HDFS)实现数据的多副本存储,确保数据的高可用性。

- 异地容灾:在不同地域部署数据仓库副本,防止单点故障导致的数据丢失。

- 自动故障转移:通过集群管理工具(如Kubernetes)实现服务的自动切换,减少停机时间。

我认为,多副本存储和异地容灾是保障数据仓库高可用性的基础,能够有效应对硬件故障和自然灾害等风险。

总结:设计一个支持大规模数据分析的数据仓库架构需要综合考虑数据存储、处理、集成和查询性能等多个方面。通过分层存储、增量ETL、并行计算和索引优化等策略,可以显著提升系统的性能和可扩展性。同时,高可用性和容灾方案是保障数据仓库稳定运行的关键。未来,随着数据湖仓一体化和实时计算技术的发展,数据仓库架构将更加灵活和高效,为企业提供更强大的数据分析能力。

原创文章,作者:IamIT,如若转载,请注明出处:https://docs.ihr360.com/strategy/it_strategy/132954